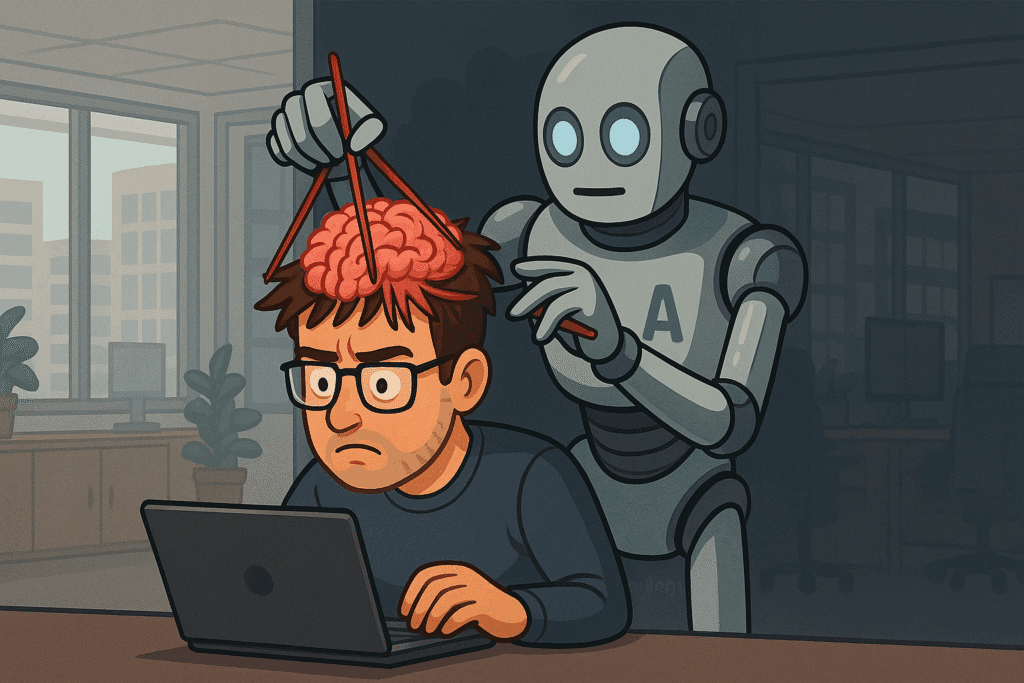

L’intelligence artificielle générative crée de la merde

À l’ère de l’intelligence artificielle générative (Generative Artificial Intelligence), nous voyons de plus en plus d’outils émerger et de personnes expérimenter la création de contenu grâce à ces outils. Mais qu’en est-il de la qualité du contenu généré. Voici mon avis après quelques réflexions autour du sujet.

C’est à la suite d’une réunion dans mon entreprise que j’ai décidé d’écrire cet article. L’IA prend une place de plus en plus forte dans le monde, professionnel comme personnel et mon entreprise nous pousse à expérimenter, comprendre et innover. Le principe de la réunion était donc de partager nos avancées, expérimentations et idées récentes.

Un développeur sénior a présenté comment il avait utilisé un agent IA pour lire le code d’un projet afin de générer une documentation expliquant son fonctionnement. Ce projet est passé d’équipes en équipes et globalement, la connaissance a été perdue et plus personne n’ose le toucher. L’idée est donc de générer de la documentation qui servira plus tard à :

- des humains pour mieux appréhender le projet et prendre des décisions ou répondre à des analyses d’impacts

- d’autres agents qui utiliseraient cette documentation comme base de connaissance pour générer du code ou répondre à des questions dans une conversation

Mais soyons clairs, le résultat généré est mauvais, très mauvais. Le document est long, non pertinent, avec des erreurs (hallucinations). Même s’il donne un aperçu rapide de ce que fait le projet, il n’est pas aussi pertinent et précis que ce qu’un humain aurait pu faire.

Donc, nous nous retrouvons dans un cas où sans relecture, le document est de la merde. Au mieux incomplet, au pire, il induira en erreur ceux qui le liront, leur faisant perdre du temps. L’apparent gain d’efficacité au début crée une perte de temps pour chaque personne qui lira ce document.

Un autre développeur rétorque qu’il vaut mieux de la documentation générée par IA que pas de documentation. Quelle erreur. Dans le cas où il n’y a pas de documentation, il faudra aller lire le code une fois et écrire la documentation appropriée. De la vraie valeur ajoutée. Prendre le temps de lire, comprendre et analyser du code pour en sortir les points clés et partager sa compréhension, c’est une vraie compétence (d’ailleurs un Senior sera meilleur pour cet exercice).

Alors est-ce que l’utilisation de l’IA met en exergue la paresse et l’incapacité d’analyse de chacun ?

Il faut utiliser l’IA comme un outil, très puissant, mais approximatif. L’analyse d’un projet inconnu par un agent, même avec le meilleur contexte, ne sera jamais au niveau de la lecture et compréhension d’un bon développeur sénior.

C’est honorable et louable d’essayer de mettre de l’IA un peu partout, mais il faut aussi savoir prendre le recul nécessaire pour analyser le résultat. Pour des tâches très précises comme de la traduction, de l’extraction de données, de la génération de code “basique”, j’y crois à fond. Mais pour des raisonnements complexes, le résultat n’est pas aujourd’hui suffisant à mes yeux.

Je parle ici de tâches confiées à l’IA en autonomie (concept d’agents). Lors de l’utilisation d’IA en mode “compagnon” avec un échange, un raisonnement structuré en étapes et de l’apport de précisions, les résultats peuvent être bluffants.

Je vous laisse avec un post Linkedin d’un ancien collègue que je comprends à 100%. Si vous utilisez l’IA, vous êtes responsable de tout ce qu’elle génère et fait. Comme avec une perceuse ou un marteau 😉

Derniers commentaires